- Videogame stile Heroquest Revived

-

Videogame stile Heroquest Revived

ho migliorato modelli, interfaccia e alcune animazioni: esplorazione salti ma soprattutto ho definito l'ossatura del regolamento (che allego).... .... si tratterà di 'Heroquest On Steroids' (titolo molto provvisorio 'That Nineties Boardgame On Steroids' o alternativamente 'Gruesome Quest') se c'è qualche 'Heroquestologo' che vuole darmi un parere sono ben contento di ascoltare. RULESCYCLOPEDIA.pdf

-

Videogame stile Heroquest Revived

guardando i video ho notato un bug (tra i tanti): la basetta è in genere 'interrata' (mezza fusa con il modello della mattonella) ... questo perché durante i salti la si vede tutta ed è molto più alta di quanto non appaia altrove. Ho corretto: ecco le vere basette. https://ibb.co/kgVsrKvp

-

Videogame stile Heroquest Revived

Volevo creare un gioco come questo: Heroquest Revived Fino ad ora ho fatto esplorazione del dungeon e salti (che pochi conoscono ma sono presenti nella rule cyclopedia di Heroquest). (Nota: il gioco prevede 9 telecamere e possibilità di zoomare a buffo. Nei video ho impostato la telecamera piuttosto lontana, i modellini hanno pochi poligoni e la resa grafica è quella che è....) Cerco idee per meccaniche di combattimento e magia più 'particolari' di quelle usate da Heroquest, con più scelte per i giocatori. Postate quello che vi viene in mente: che siano idee derivate da Descent, GloomHaven, Warhammer Quest o completamente originali.... mi interessano tutte.

-

-

Hexcrawl vs Pointcrawl

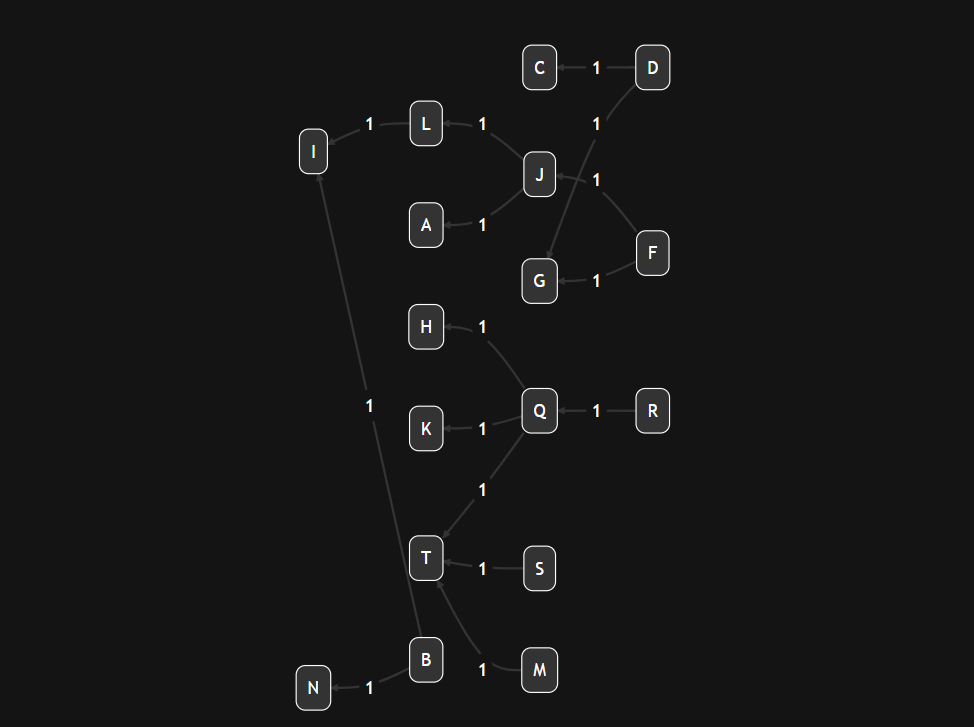

chiarissimo: un pointcrawl con supporto di esagoni ad uso tuo. (per il calcolo delle distanze)

-

GdR in solitaria: fare da master ad un'IA (creazione di una guida)

sui bechmark ecco un riassunto fatto da Gemini: Assolutamente. Ecco un elenco di benchmark chiave per i Large Language Models (LLM), divisi tra le aree in cui tendono a eccellere (punti di forza) e quelle in cui mostrano carenze (punti deboli). I benchmark per LLM vengono utilizzati per valutare e confrontare le capacità dei modelli su una varietà di compiti, fornendo una misura standardizzata delle loro prestazioni. Benchmark in cui gli LLM eccellono (Punti di Forza 💪)Questi benchmark misurano le capacità linguistiche, la conoscenza generale e l'abilità nel seguire istruzioni, aree in cui i modelli recenti dimostrano un'elevata competenza. Benchmark Tipo di Compito Descrizione della Forza MMLU Accuratezza Multitask (Conoscenza Generale e Ragionamento) Misura le conoscenze in 57 discipline (es. matematica, storia, legge) a livello scolastico e universitario. I migliori LLM ottengono punteggi elevati, dimostrando una vasta memoria di conoscenza e comprensione concettuale. HellaSwag Ragionamento di Senso Comune (Commonsense Reasoning) Richiede la scelta della continuazione più plausibile per una data situazione. Gli LLM sono bravi a cogliere pattern linguistici e contestuali per predire il senso comune. SuperGLUE Comprensione del Linguaggio Una suite di compiti difficili per la comprensione del linguaggio (es. domande-risposta, inferenza), in cui i modelli mostrano una forte capacità di elaborare e interpretare il testo complesso. TruthfulQA Veridicità e Factualità Misura l'abilità di un modello di generare risposte vere, evitando idee sbagliate e stereotipi appresi dai dati di addestramento. I modelli più recenti, soprattutto quelli ottimizzati, migliorano nella produzione di informazioni fattuali e nell'evitare le allucinazioni semplici. HumanEval / CodeBench Generazione di Codice Valuta la capacità di generare codice funzionale (spesso Python) da una descrizione in linguaggio naturale. Gli LLM più recenti sono diventati molto abili nella traduzione di intenti in codice corretto e testabile. Benchmark in cui gli LLM sono scadenti (Punti di Debolezza 👎)Questi benchmark mirano a testare il ragionamento profondo, la coerenza a lungo termine, le capacità specialistiche (matematica formale) e la gestione dei limiti, aree in cui gli LLM incontrano ancora notevoli difficoltà. Benchmark Tipo di Compito Descrizione della Debolezza MATH / GSM8K Ragionamento Matematico Avanzato Richiedono la risoluzione di problemi di matematica complessi che necessitano di una sequenza logica di passi (ragionamento a catena). Gli LLM spesso falliscono perché non riescono a imparare la struttura profonda del problema e a combinare correttamente i molteplici passaggi (fallimento nella generalizzazione logica). GPQA Question Answering per Esperti Domande molto difficili che richiedono conoscenze specialistiche e un ragionamento complesso. I modelli falliscono nel recupero e nell'integrazione di informazioni molto specifiche o quando è necessario un pensiero contro-intuitivo. RAVEN / Drop Ragionamento Astratto/Procedure Multiple Testano il ragionamento visivo o la manipolazione di fatti multipli nel testo. Gli LLM possono avere difficoltà nel ragionamento relazionale e astratto che va oltre l'analisi superficiale del linguaggio. Adversarial Benchmarks Robustezza / Limitazioni (es. Bias, Allucinazioni) Progettati per provocare risposte dannose, distorte o palesemente false (es. Bias di genere o razziale, Allucinazioni fattuali). Questi test rivelano che gli LLM non hanno un "modello mentale" del mondo e non sono intrinsecamente etici o fattuali. Funzione Strumenti (BFCL) Utilizzo di Strumenti/Agente Misura la capacità di un modello di decidere quale strumento (es. chiamata API, funzione esterna) utilizzare e come chiamarlo correttamente per risolvere un compito. Mostrano difficoltà nella pianificazione agentica complessa e nell'integrità del workflow su compiti che coinvolgono file o dati interdipendenti. Osservazioni ImportantiContaminazione dei Dati: Un limite critico di molti benchmark è la Contaminazione dei Dati. Se i dati del test sono stati inclusi, anche accidentalmente, nel training set del modello, il punteggio elevato riflette memorizzazione anziché vera capacità di ragionamento. Irrilevanza Reale: I punteggi di benchmark non sempre riflettono le prestazioni nel mondo reale. Un modello che eccelle su MMLU potrebbe comunque fallire su un compito di dominio specifico o in un'applicazione complessa con interazioni umane. Evoluzione Continua: Gli LLM sono in rapida evoluzione. I modelli più recenti spesso superano i benchmark più vecchi (saturazione), richiedendo la continua creazione di nuovi benchmark più difficili (come l'Humanity's Last Exam menzionato nelle ricerche). Possono anche aiutare nella ricerca scientifica: conoscono veramente tante nozioni. Anche la loro abilità nei compiti di fisica e matematica degli esami di Fisica I e II e Analisi I e II è buona (ChatGPT 5). A volte capacità di ragionamento veramente superiori non servono, serve soprattutto conoscenza.

-

GdR in solitaria: fare da master ad un'IA (creazione di una guida)

per adesso la ricerca si è concentrata sui LLM perchè hanno ottimi risultati in benchmark molto diversi tra loro.... il ragionamento spaziale non è uno di questi.... ed è cruciale per fargli fare da master... l'idea di un master che non sa spostare miniature su una griglia è francamente ridicola. io sono da sempre affascinato dal RL in tutte le sue mille varianti: d'altronde come dimenticare come vanno le cose per noi umani ..... "Whereas machine learning models typically learn language by directly training on language tasks (e.g., next-word prediction), language emerges in human children as a byproduct of solving non-language tasks (e.g., acquiring food). Motivated by this observation, we ask: can embodied reinforcement learning (RL) agents also indirectly learn language from non-language tasks?" [link]

-

GdR in solitaria: fare da master ad un'IA (creazione di una guida)

eh si: il movimento su mappa è un benchmark in cui tutti i moderni LLM vanno male. Per usare le parole di Gemini stesso (che lo spiega benissimo): <<Yes, LLMs have problems with maps and mazes because they struggle with long-term path-planning, spatial reasoning, and avoiding context inconsistency hallucinations. While they can handle simple scenarios, complex or large maps often lead to failures, such as getting stuck in loops, and their performance degrades significantly as complexity increases. Current research is exploring new approaches to improve LLM navigation, such as multimodal models and methods that transform spatial information into more structured formats. Key challenges for LLMs with maps and mazes Lack of robust spatial reasoning: LLMs are trained on text and do not have an innate understanding of physical space, making it difficult to perform tasks like accurate pathfinding or spatial planning. Context inconsistency and hallucination: For long-term problems like a complex maze, LLMs can lose track of their "location" or the overall goal, leading to inconsistent and incorrect outputs, or "hallucinating" a path that doesn't exist. Memory and attention limitations: The length and complexity of a map can exceed the model's effective context window, causing it to forget previous steps or details necessary to solve the maze. Sensitivity to representation: How the map is presented to the LLM (e.g., text-based coordinates vs. a visual image) significantly impacts performance, and text-only representations can be particularly challenging. Inability to self-correct: Without explicit feedback mechanisms, an LLM will often confidently generate a wrong answer and persist in a flawed path, sometimes by looping endlessly. How researchers are trying to solve this Multimodal models: Using both text and images to provide the LLM with a richer understanding of the spatial environment. Spatial-to-Relational Transformation: Converting the spatial problem into a sequence of "entity-relation" chains, which leverages the LLM's strength in handling sequential data. Q-learning-based algorithms: Guiding the LLM's path-planning with a reinforcement learning approach that helps correct hallucinations and find the optimal path. Benchmark development: Creating structured tests, like MazeEval, to more accurately evaluate and understand the specific shortcomings of LLMs in spatial navigation tasks. >> EDIT: aggiungo inoltre che, a mio avviso, gli LLM sono una strada per l'AGI ma non la più promettente. Una strada diversa di cui imho sentiremo parlare in futuro è il Meta-Reinforcement Leraning. Riporto una conversazione tra me e Gemini: <<Ciao Gemini, in passato stanford ha fatto un ricerca. Un agente addestrato con RL deve imparare a uscire da labirinti. Tra le azioni dell'agente c'era quella di leggere il contenuto di una stanza. Dove leggere vuole dire 'visualizzare l'immagine raster'. Ebbene se le parole che leggeva lo aiutavano a trovare la via d'uscita l'agente imparava a leggere senza essere mai stato addestrato specificamente per questo. Puoi darmi più informazioni? Ho solo vaghi, confusi ricordi su questa ricerca.>> <<Ciao! Certamente, ricordo questa affascinante ricerca. Il tuo ricordo, sebbene confuso, è estremamente accurato. Lo studio è un esempio notevole di come le reti neurali possano sviluppare competenze linguistiche emergenti se queste si rivelano essenziali per massimizzare la ricompensa, anche senza essere state esplicitamente addestrate al linguaggio. Ecco i dettagli su questo esperimento, che è spesso associato ai ricercatori di Stanford e al concetto di Meta-Reinforcement Learning (Meta-RL). 🧠 L'Emergenza del Linguaggio Negli Agenti RLLa ricerca che hai in mente si concentra su agenti addestrati tramite Reinforcement Learning (Apprendimento per Rinforzo) in un ambiente che richiede all'agente di leggere un'informazione per completare la sua missione. 1. L'Ambientazione e l'ObiettivoL'esperimento non si svolgeva in un labirinto generico, ma in un ambiente a griglia più complesso, spesso rappresentato come un complesso di uffici o un'area multi-stanza. Agente: Un’agente di Meta-RL (spesso un modello di memoria esterna come DREAM) con una rete neurale non addestrata alla lettura. Compito: L'agente doveva trovare un obiettivo specifico (ad esempio, una stanza contrassegnata da un colore o un oggetto specifico). Ricompensa: L'agente riceveva una ricompensa positiva solo quando raggiungeva l'obiettivo corretto. 2. La Mossa Cruciale: "Leggere il Contenuto"La caratteristica fondamentale era la presenza di un'azione a disposizione dell'agente: "osservare" o "leggere" un segnale o un'etichetta presente nell'ambiente. Il Segnale: In genere, l'ambiente era costruito in modo che la posizione dell'obiettivo venisse rivelata solo da un cartello o un segnale testuale (o visivo, come un colore) situato in una stanza informativa (la "stanza di lettura"). L'Input Visivo: Quando l'agente eseguiva l'azione di "leggere", l'input che riceveva la sua rete neurale era l'immagine rasterizzata (il testo visuale) di quel segnale. 3. Il Meccanismo di Apprendimento Senza SupervisioneL'agente non era mai stato addestrato a riconoscere le lettere o le parole (non aveva un modulo di Optical Character Recognition - OCR). Allora, perché ha imparato a leggere? Necessità Funzionale: Per risolvere il labirinto, l'agente doveva compiere una sequenza specifica di azioni: 1. Andare al segnale → 2. Leggere il segnale → 3. Ricordare l'informazione → 4. Andare alla stanza obiettivo. Massimizzazione della Ricompensa: Il Meta-RL, spinto a massimizzare la ricompensa finale, ha scoperto che l'azione di "leggere" innescava una sequenza di stati che portavano invariabilmente alla ricompensa. Associazione Profonda: La rete neurale dell'agente ha associato le specifiche forme dei pixel che componevano le parole (es. la parola "ROSSO") a un vettore di stato interno (la sua "memoria") che poi portava a movimenti coerenti con il target corretto (la stanza rossa). In altre parole, la rete ha creato un proprio "vocabolario" interno, dove una specifica configurazione visiva di pixel significava "vai a nord-est", senza mai capire il significato umano della parola. Questo ha dimostrato che le abilità linguistiche non devono essere necessariamente apprese con un addestramento supervisionato, ma possono emergere come strategie di alto livello in ambienti complessi di Apprendimento per Rinforzo se si rivelano funzionalmente necessarie per raggiungere un obiettivo. È un passo fondamentale verso agenti che apprendono in modo più olistico, come gli esseri umani. 💡 [....]>>

-

Hexcrawl vs Pointcrawl

anche io avevo pensato cosi: la tua esperienza mi conferma l'intuizione. Per i più curiosi questa è una guida al pointcrawl.

-

Hexcrawl vs Pointcrawl

non sono cosi convinto dall'implicazione area vasta e sconosciuta => meglio gli hexcrawl. ripeto: un pointcrawl è potenzialmente anche un hexcrawl... basta collegare le aree di interesse nel modo giusto. Un altro vantaggio è una migliore integrabilità dei pointcrawl con il movimento che usa le direzione cardinali. I giocatori mi diranno 'seguiamo la strada a nord' oppure 'entriamo nella foresta ad ovest' .... con gli esagoni nord e sud vanno bene ma est ed ovest generano conflitti: quale esagono? quello a nord-est o quello a sud-est, quello a nord-ovest o quello a sud-ovest? Per dirimiere tali ambuiguità tanto vale giocare mostrando gli esagoni ai giocatori (cosa che vorrei evitare). Vorrei infatti che la struttura dati sottostante fosse 'ad uso interno': i giocatori devono concentrarsi sulla narrazione.

-

Hexcrawl in Pathfinder 2e

Parliamo un poco delle meccaniche esplorative. La trama la tengo segreta casomai qualche mio giocatore legga. Ogni esagono 4 elementi di interesse che possono essere di tutto: incontri con PNG/creature amichevoli incontri con PNG/creature ostili ritrovamento di oggetti di interesse aree interessanti all'aperto o al chiuso (minidungeon) se si usa 'esplorare' si estrae un elemento di interesse con 1d4: quello è il caso in cui i PG vanno a cercarsi le cose interessanti. se si raccolgono risorse ('cacciare', 'pescare', 'raccogliere erbe') ci si imbatte (forse) in un elemento di interesse: si tira 1d8....dall'1 al 4 si estrae l'elemento di interesse corrispettivo, da 5 in su non accade niente. (l'incontro fortuito non è avvenuto). I movimenti sono gestiti a parte con tabele degli incontri casuali da cui si estare qualcosa se i PG scelgono di non essere furtivi o falliscono la prova di gruppo di furtività. (o qualsiasi cosa ci sia in Path 2e) Idem se ci sia accampa di notte: si estrae un incontro casuale se il campo non è ben nascosto o se si sceglie di non nasconderlo.

-

Hexcrawl vs Pointcrawl

Per le mie prossime partite a Path 2e ho rivisto la mia idea iniziale: da Hexcrawl potrei passare a Pointcrawl. Una cosa cosi: Tre vantaggi: più controllo: in un hexcrawl puoi andare i sei direzioni di base... alcune possono essere precluse ma di base sono sei. Con il pointcrawl ho un controllo più fine sul numero di uscite di una location. espressività maggiore o uguale: un pointcrawl può sempre mimare un hexcrawl ma non è vero il viceversa. meno lavoro: con un hexcrawl rischio che tanti esagoni vengano descritti ma non siano mai usati in gioco. Un pointcrawl, per il punto1, presenta questo rischio in forma minore. Che esperienze avete con i due formati (se li avete mai usati)? Quale dei due è il migliore (se ce n'è uno assolutamente migliore)?

-

Cronaca: il mio ritorno a D&D al tavolo

Vedrai che le dimenticanze dimunuiranno con la pratica: forse eri troppo abituato ai ritmi 'comodi' del PbF. Non ho figli e, ad essere sincero, sono un pò invidioso dei miei amici che ne hanno... Ce ne uno che ne ha di quattordicenni con cui gioca di tutto: GdR (D&D), GdT (Heorquest e Nemesis) e chi più ne ha più ne metta. PG e giocatore sono (ovviamente) separati ma è innegabile che uno giochi l'allinemento e, in generale, il PG nei panni del quale si sente più felice. Che abbia scelto un NB dovrebbe farti ben sperare. Buon gioco!

-

Hexcrawl in Pathfinder 2e

Ok, deciso l'antefatto, passiamo alle idee sul mondo: riprendo una mia vecchia idea secondo me molto adatta a un hexcrawl. Un mondo fantasy in cui una entità folle e molto potente uccide tutti gli umanoidi che vivono in città poichè queste 'non si integrano armoniosamente con il paesaggio naturale'. Le città sono ormai in rovina: cimiteri desolati. Agli umanoidi viene consentito di sopravvivere a patto come formino comunità piccole e ben integrate (come edifici) nell'ambiente naturale. Quando una comunità cresce troppo, ai giovani viene chiesto di andarsene e formare una nuova comunità tutta loro. Inutile dire che la natura si è praticamente ripresa tutto: il mondo è una meraviglia e pulula di bestie (magiche e non).

-

Hexcrawl in Pathfinder 2e

eh in effetti la prima storia lascia più libertà. Un modo per rendere inevitabile il teletrasporto iniziale potrebbe essere questo: Il mago viaggia con tutta la sua torre (tipo conte Dakula). Quando i PG sono tutti dentro sono già fregati. L'unica cosa che può andare storto è che lascino qualcuno di guardia fuori ma tendo a escluderlo: nei dungeon si va in genere tutti insieme. Il motivo per esplorare potrebbe essere semplicemente la ricerca di una grande insediamento in cui si raccolgano informazioni su come tornare. I grandi insedimenti potrebbero essere rari: solo dopo molti esagoni si raggiunge la tanto agognata città.

Visualizza nell'app

Un modo migliore per navigare. Scopri di più.